En los Navy SEALs, la unidad de operaciones especiales más exigente de EE. UU., existe una matriz en dos ejes, tan simple como poderosa, para evaluar a cada candidato: rendimiento y confianza.

El primero mide lo que es capaz de hacer un candidato: su eficacia, su técnica y sus resultados. Mientras, el segundo mide si se puede contar con esa persona en cualquier circunstancia: su lealtad, coherencia y fiabilidad.

El hallazgo de los SEALs es revelador: prefieren a alguien de confianza con un rendimiento medio antes que a una ‘máquina’ en resultados pero tóxico para el grupo porque, en una misión de riesgo, la confianza puede marcar la diferencia entre el éxito y el fracaso.

Y aunque esta reflexión nace en el ámbito militar, se puede aplicar a muchos otros terrenos, como las amistades, los equipos de trabajo, los negocios… y, en el caso que nos ocupa, a la Inteligencia Artificial.

¿Cómo se puede traducir esta lógica al mundo de la IA?

En la actualidad, evaluamos a la inteligencia artificial con un criterio casi obsesivo: su rendimiento. Nos fascina su capacidad para procesar millones de datos en segundos, redactar textos complejos o generar imágenes realistas. Pero pocas veces nos detenemos a valorar el otro eje: la confianza.

Rendimiento en IA: la cara más visible

En el mundo digital, el rendimiento se traduce en:

- Precisión: qué tan correctos son sus resultados, como diagnosticar una enfermedad, traducir un texto o generar un informe.

- Velocidad: la rapidez con la que procesa millones de datos.

- Escalabilidad: la posibilidad de aplicar la misma tecnología en distintos sectores o a miles de usuarios a la vez.

- Innovación: su capacidad de encontrar soluciones novedosas a problemas complejos.

El rendimiento, sin duda, es lo más espectacular y fácil de medir. Pero no lo es todo.

Confianza en IA: el factor invisible

Evidentemente, la confianza es más difícil de evaluar, pero es igual o más importante, ya que incluye aspectos como:

- Transparencia y explicabilidad (XAI): poder entender cómo llega a un resultado.

- Seguridad: protección de datos y resistencia frente a ciberataques.

- Equidad: ausencia de sesgos que discriminen a colectivos o individuos.

- Cumplimiento normativo y ético: respeto a leyes y principios fundamentales.

- Robustez: que el sistema no falle o se derrumbe ante lo inesperado.

Además, los grandes modelos de lenguaje (LLM), como los que hoy usamos a diario en nuestros ordenadores o móviles, presentan limitaciones que alimentan esta desconfianza:

- Alucinaciones y errores factuales: generan respuestas seguras en tono, pero erróneas o inventadas.

- Falta de memoria persistente: cada interacción empieza de cero, salvo que se reintroduzca el contexto manualmente.

- Inteligencia irregular: brillan en algunas tareas (resumir, generar código), pero son sorprendentemente débiles en otras.

Sin confianza, cualquier avance técnico se convierte en una apuesta arriesgada. Y estos límites hacen evidente que la IA necesita supervisión y verificación humana para que la confianza no sea ciega, sino razonada.

La matriz aplicada a la IA

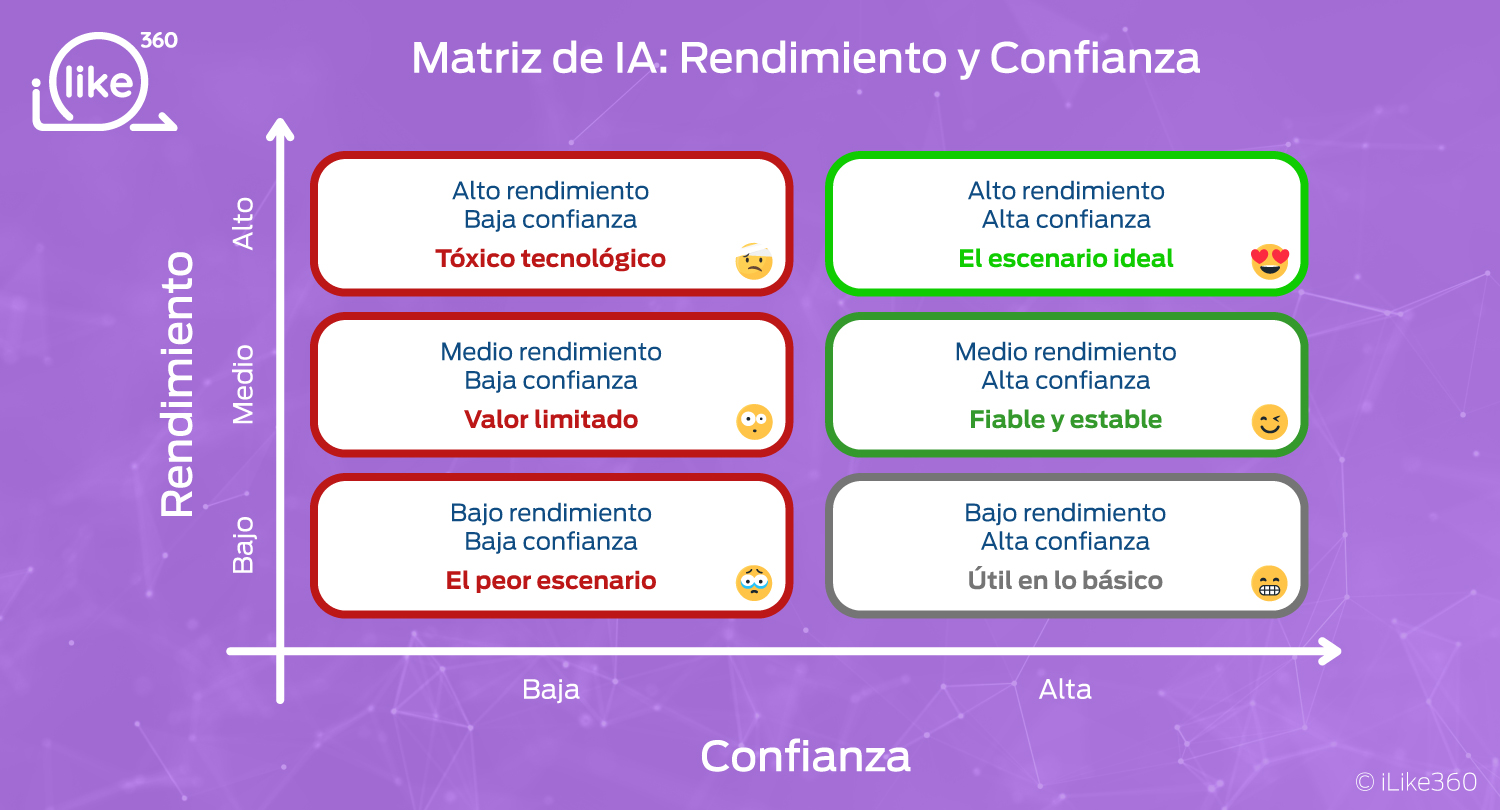

Si trasladamos la matriz de los SEALs al ámbito de la inteligencia artificial, podemos distinguir tres niveles de rendimiento —bajo, medio y alto—, porque la capacidad técnica sí puede medirse en grados. En cambio, la confianza es más absoluta: o se tiene o no se tiene.

Al cruzar ambos ejes, aparecen seis escenarios posibles:

- Alto rendimiento + alta confianza → El escenario ideal. Una IA potente, transparente, ética y segura se convierte en un aliado estratégico de primer nivel.

- Alto rendimiento + baja confianza → El “tóxico” de la tecnología: brilla en resultados, pero genera desconfianza por sus sesgos, falta de explicabilidad o riesgos legales.

- Rendimiento medio + alta confianza → Una IA estable y fiable, quizás menos espectacular, pero seguramente la más adecuada para organizaciones que buscan avanzar con seguridad.

- Rendimiento medio + baja confianza → Mediocre en resultados y poco confiable: aporta poco valor y puede convertirse en un obstáculo más que en una ayuda.

- Bajo rendimiento + alta confianza → Aunque es confiable, su escasa capacidad técnica la limita a tareas menores o muy concretas.

- Bajo rendimiento + baja confianza → El peor de los escenarios: ni funciona bien ni inspira credibilidad.

El papel de las personas en el proceso

Como siempre insisto, el equilibrio entre rendimiento y confianza en la IA no depende únicamente de los algoritmos. Las personas seguimos siendo el elemento central, ya que somos quienes definimos el contexto, verificamos los resultados y asumimos la responsabilidad última de su uso.

Esto implica mantener un humano en el loop (bucle): alguien que supervise, contraste la información y decida cuándo confiar en lo generado por la máquina. Además, las organizaciones deben crear una cultura que fomente la transparencia, la ética y la responsabilidad compartida, porque la confianza tecnológica no se construye sólo con software, sino con decisiones humanas.

Una lección… de vida o muerte

Lo que los SEALs aplican a la vida o la muerte, nosotros deberíamos aplicarlo a todas las facetas de nuestra existencia: en las relaciones personales, en el trabajo, en los equipos y, por supuesto, en la adopción de nuevas tecnologías.

En el caso de la Inteligencia Artificial, la conclusión es clara: no basta con que rinda mucho, necesitamos que sea confiable. Una IA espectacular pero opaca puede comprometer la reputación, la seguridad y la confianza de clientes y ciudadanos. En cambio, una IA quizá menos brillante, pero transparente y robusta, construye relaciones sólidas y sostenibles.

En un mundo donde la inteligencia artificial promete transformar todos los sectores, conviene recordar la enseñanza de los equipos más exigentes: la confianza no es negociable.